本篇博文,讲解与配置Atlas与Hive的集成,以及其中遇到的一些问题,然后把hive的元数据信息导入到atlas里面,我们就可以直观的去看。

这边文章主要在于集成hive,其中的比如一下安装hadoop,hive等,可以查看我之前的博客。该集成不涉及到元数据血缘关系,主要通过atlas自身的导入脚本离线导入元数据,血缘以及实时导入将在后面的博文中介绍。

配置Hive

配置,Hive安装目录/conf/hive-site.xml 添加:

1

2

3

4<property>

<name>hive.exec.post.hooks</name>

<value>org.apache.atlas.hive.hook.HiveHook</value>

</property>配置,Hive安装目录/conf/hive-env.sh 添加:

1

export HIVE_AUX_JARS_PATH=$atlas编译好的安装目录/hook/hive

例如我这里修改为:

export HIVE_AUX_JARS_PATH=/opt/dev/idea/apache-atlas-sources-2.0.0/distro/target/apache-atlas-2.0.0-bin/apache-atlas-2.0.0/hook/hive

下载

- 我下载的最新版apache atlas 2.0:https://atlas.apache.org/Downloads.html

- 下载后解压,进入该目录,然后开始编译。

- 命令:

mvn clean -DskipTests install (atlas使用外部hbase和solr服务)

mvn clean -DskipTests package -Pdist,embedded-hbase-solr (atlas使用自带的hbase和solr服务)

- 我目前使用他自带的服务hbase、solr服务.命令:mvn clean -DskipTests package -Pdist,embedded-hbase-solr

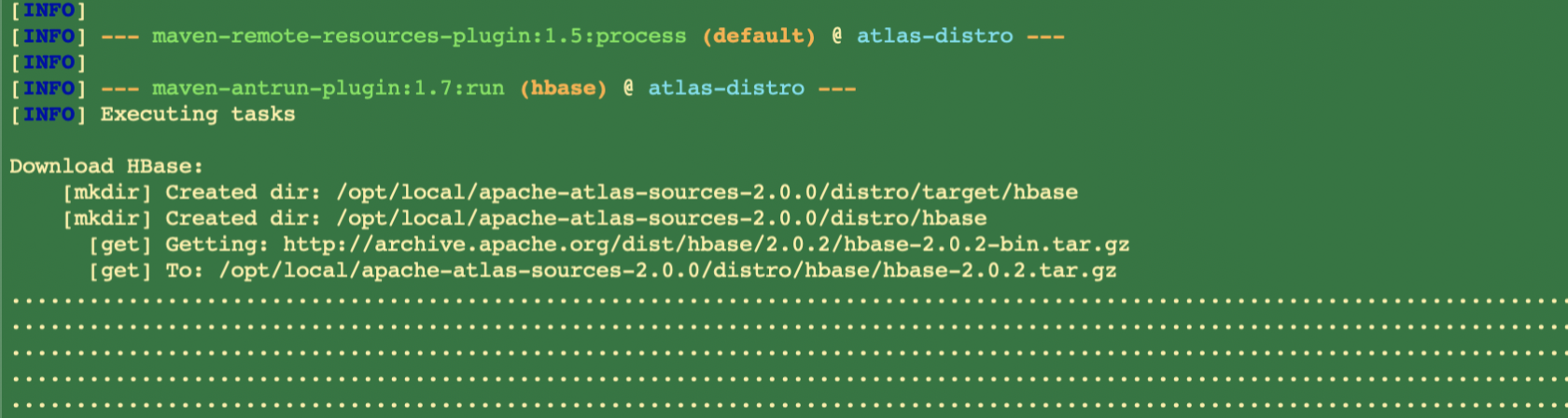

- 这个过程有点长,主要是这里,如果使用自带的服务需要下载一个hbase,100多MB

- 如果不想等,可以自己手动下载然后放入下面提示的目录,即通过:http://archive.apache.org/dist/hbase/2.0.2/hbase-2.0.2-bin.tar.gz下载

- 因为有了之前的经验,前面已经讲过HBase-通过idea搭建源码阅读环境所以下面讲的比较简洁,很多配置类似。

修改配置文件

zookeeper 服务启动

启动服务的时候需要一个配置文件,在conf目录下修改zoo_sample.cfg为zoo.cfg

配置QuorumPeerMain

- 配置:

VM options:-Dlog4j.configuration=file:/opt/dev/idea/zookeeper/conf/log4j.properties

Program arguments:/opt/dev/idea/zookeeper/conf/zoo.cfg

启动类为:org.apache.zookeeper.server.quorum.QuorumPeerMain

该篇文章主要是,搭建一个HBase的源码阅读环境。主要是通过github下载源码,编译导入到开发环境idea中,然后启动相关服务,做DeBug调试来阅读相关源码。

下载HBase源码

通过github下载相关源码(我下载到目录:/opt/dev/idea/hbase )

- 注意:默认我们克隆时,会把所有的历史commit信息也会克隆下载。

对于一个非常活跃的开源项目来说这些历史信息非常占用空间,下载时就会很慢。

我们可以在git clone 后面加一个--depth 1这样只克隆最新的一次提交(深度为1),就会快很多,如下:git clone https://github.com/apache/hbase.git –depth 1

当前网速较慢或者你使用的浏览器不支持博客特定功能,请尝试刷新或换用Chrome、Firefox等现代浏览器